„Jesteśmy o krok od chwili, gdy AI będzie prowadziła badania naukowe samodzielnie”

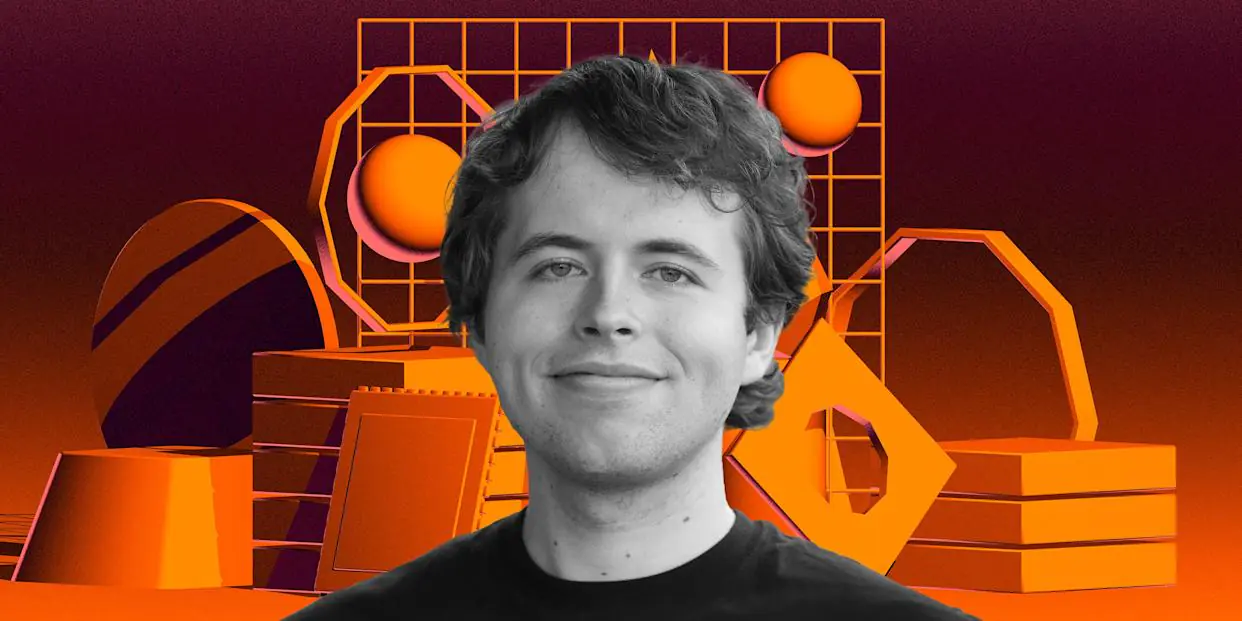

„Tworzenie oryginalnych badań naukowych to dla mnie najbliższa emocjonalnie definicja AGI” – mówi Jakub Pachocki, główny naukowiec OpenAI. AGI (Artificial General Intelligence) to sztuczna inteligencja, która potrafi uczyć się i rozwiązywać nowe problemy równie skutecznie jak człowiek.

To zdanie nie pada w eseju futurologa, lecz w wywiadzie opublikowanym przez Nature – jeden z najbardziej prestiżowych magazynów naukowych na świecie.

Pachocki nie mówi, że AI kiedyś tam może pomóc nauce. Mówi, że jesteśmy o krok od chwili, gdy maszyny będą prowadziły badania naukowe niemal samodzielnie: generowały hipotezy, analizowały dane, tworzyły nowe idee. Co to oznacza dla nauki, dla ludzi i dla samego pojęcia inteligencji?

To jedna z najciekawszych rozmów o przyszłości sztucznej inteligencji, jaką opublikowało Nature. Tym razem redakcja wzięła pod lupę nie tyle samą technologię, co ludzi, którzy ją tworzą – i pytania, które wciąż pozostają bez odpowiedzi. To o Pachockim Sam Altman, prezes OpenAI, powiedział, że jest “jednym z najjaśniejszych umysłów naszej generacji“.

Czy AI potrafi myśleć? I czy jest w stanie prowadzić oryginalne badania naukowe?

Brzmi jak science fiction? Dla Jakuba Pachockiego – już nie. Pachocki, który od 2024 roku kieruje zespołem badawczym OpenAI, przyznał w rozmowie z Nature, że jego poglądy na temat sztucznej inteligencji przeszły rewolucję.

Kiedy zaczynał pracę w firmie w 2017 roku, był jednym z największych sceptyków – nie wierzył, że AI szybko przekroczy granice wyznaczone przez grę w Go czy test Turinga.

Dziś twierdzi, że „najtrudniejsze benchmarki zostaną pokonane szybciej, niż nam się wydaje”.

Od ChatGPT do modeli rozumowania

Większość z nas zna OpenAI głównie z ChatGPT – czatbota, który w 2022 roku szturmem wdarł się do domów, szkół i biur na całym świecie.

Ale za kulisami toczy się dużo poważniejsza gra. OpenAI rozwija tzw. modele rozumowania – narzędzia, które potrafią analizować dane krok po kroku, dochodzić do logicznych wniosków, a nawet – jak mówi Pachocki – „pracować bez nadzoru przez 10–20 minut i wygenerować coś użytecznego”.

Czyli co dokładnie? „Deep Research”, narzędzie, które potrafi syntetyzować ogromne ilości informacji w ChatGPT, pisze kod, stawia hipotezy badawcze, wykonuje głębokie przeglądy literatury naukowej – słowem: wszystko, co do tej pory wymagało ludzkiego umysłu. A to dopiero początek.

„Spodziewam się, że pojawią się modele AI rzeczywiście zdolne do prowadzenia oryginalnych badań. Zobaczymy duży postęp na przykład w autonomicznym inżynierii oprogramowania, autonomicznym projektowaniu komponentów sprzętowych i podobnych zastosowaniach w innych dziedzinach”, mówi Pachocki.

Czy AI naprawdę rozumuje? A może tylko naśladują coś, co wygląda jak rozumowanie?

Czy AI myśli? Nie do końca tak, jak człowiek – i Pachocki nie ukrywa tej różnicy. „Model wytrenowany na danych wie coś o świecie, ale nie wie, jak i kiedy się tego nauczył” – mówi. Nie ma świadomości czasu, przyczyny, ani procesu. A jednak jest w stanie łączyć informacje i tworzyć z nich nowe struktury – czyli coś, co dla nas wygląda jak rozumowanie.

„Jednak jestem przekonany, że mamy istotne dowody na to, iż modele są w stanie odkrywać nowe spostrzeżenia. Powiedziałbym, że to forma rozumowania — choć nie taka, jaką posługują się ludzie”, twierdzi Pachocki.

To właśnie dlatego tak ważne jest uczenie przez wzmacnianie – metoda, w której model uczy się poprzez próbę, błąd i informację zwrotną.

Początkowy etap, jak tłumaczy Pachocki, to beznadzorowy trening na dużych zbiorach danych – „budowanie modelu świata”. Dopiero później następuje faza, w której AI uczy się, co jest przydatne, a co nie. I co warto myśleć.

Kiedy AGI? Czyli kiedy maszyna stanie się „ogólnie inteligentna”?

Pachocki przyznaje, że jego wcześniejsze założenia okazały się błędne. „Myślałem, że opanowanie gry w Go zajmie dziesięciolecia. Stało się to w 2016 roku” – zauważa. Dziś mówi otwarcie: kolejnym wielkim krokiem nie jest test Turinga, tylko ekonomiczny wpływ AI – czyli sytuacja, w której maszyny nie tylko wspierają człowieka, ale same tworzyć wartość.

„Jeszcze w tym roku AI może nie rozwiąże największych problemów nauki, ale stworzy wartościowe oprogramowanie – niemal całkowicie autonomicznie” – twierdzi. I dodaje: „Tworzenie oryginalnych badań naukowych to dla mnie najbliższa emocjonalnie definicja AGI”.

Open-source? Tak, ale z ograniczeniami

W rozmowie pojawia się też wątek otwartości. OpenAI – mimo nazwy – nie słynie z udostępniania modeli. Ostatni z otwartymi wagami to GPT-2 z 2019 roku. Teraz firma szykuje nowy model open-source, chociaż – jak podkreśla Pachocki – „nie będzie to model graniczny, czyli z najnowszej linii”. Dlaczego? Z obawy o bezpieczeństwo.

„Czujemy coraz większą odpowiedzialność za to, jak wdrażamy te systemy. Chcemy wypuścić coś lepszego niż obecnie dostępne modele open source” – zapewnia.

Co to wszystko oznacza dla nas?

To nie jest wywiad dla geeków. To rozmowa o tym, jak zmienia się świat pracy, nauki, kreatywności. Jeśli AI potrafi pisać kod, projektować sprzęt, generować hipotezy i tworzyć oprogramowanie – zmienia się rola człowieka.

Z twórcy staje się projektantem systemów. Z wykonawcy – strategiem.

I to już się dzieje. „Dziś AI to jeszcze asystent, który wymaga prowadzenia. Ale to właśnie się zmieni” – zapowiada Pachocki.

Punktem zwrotnym nie będzie już test Turinga, ale moment, w którym sztuczna inteligencja zacznie realnie tworzyć wartość – naukową, biznesową, społeczną

„Kolejnym naprawdę wielkim kamieniem milowym, który mam na myśli, jest sytuacja, gdy AI zacznie wywierać mierzalny wpływ ekonomiczny, a w szczególności — będzie w stanie tworzyć oryginalne badania naukowe. To dla mnie najbliższe emocjonalnie temu, co kiedyś rozumiałem jako AGI. Nad tym właśnie pracujemy i w tym zakresie spodziewam się bardzo dużego postępu jeszcze przed końcem tej dekady. Już w tym roku spodziewam się, że AI — nawet jeśli nie rozwiąże najważniejszych problemów naukowych — to stworzy wartościowe oprogramowanie, niemal całkowicie autonomicznie“, twierdzi Pachocki.

Źródło:

Nature. (2025, May 14). OpenAI’s ‘deep research’ tool: is it useful for scientists?

https://www.nature.com/articles/d41586-025-01485-2

Tag:ai w nauce, openai